Générateur de Robots.txt : contrôler les bots IA sur Webflow

Générez un fichier robots.txt personnalisé pour contrôler quels robots d'indexation IA peuvent accéder à votre site Webflow. Choisissez parmi plus de 15 bots IA dont ChatGPT, Claude ou Perplexity ainsi que des moteurs de recherche traditionnels comme Google ou Bing. C'est un fichier indispensable pour le référencement dans les LLMs.

Restreinte l'accès à certaines pages / dossiers

Choisir les bots autorisés

Prinicipaux Bots IA

Principaux bots des moteurs de recherche

Copier le contenu

Pourquoi adapter votre robots.txt aux IA ?

Les modèles d’IA comme ChatGPT, Claude ou Perplexity parcourent désormais le web pour alimenter leurs modèles ou fournir des réponses en direct.

Un robots.txt optimisé pour ces nouveaux bots permet de :

- décider quelles pages peuvent être analysées par les IA ;

- protéger des zones sensibles (pricing, contenus privés, back-office…) ;

- améliorer la diffusion de vos contenus publics dans les réponses générées par les LLM ;

- limiter la charge serveur causée par des crawls trop intensifs ;

- définir des règles cohérentes entre les moteurs classiques et les agents IA.

Si vous souhaitez suivre l’activité des bots sur votre site, vous pouvez consulter la visibilité et la fréquence de crawl sur Cloudflare Radar

Bots IA vs moteurs de recherche : quelle différence ?

Tous les bots ne poursuivent pas les mêmes objectifs :

- Googlebot explore vos pages pour les indexer dans la recherche classique.

- GPTBot, ClaudeBot, PerplexityBot, Applebot-AI… analysent votre contenu pour nourrir des modèles IA ou générer des réponses.

Leur comportement diffère également :

- vitesse de crawl plus variable,

- objectifs non liés au SEO traditionnel,

- utilisation possible de votre contenu dans des réponses, résumés, citations.

Le résultat :

- Google agit sur votre positionnement SEO,

- les LLM influencent votre visibilité dans les réponses d’IA, un nouvel espace d’acquisition.

Les limites d’un robots.txt

Le robots.txt reste un fichier déclaratif, ce n’est pas une mesure de sécurité ;

- il n’empêche pas l’accès direct à une page via son URL ;

- il repose sur la bonne volonté des bots qui choisissent de le respecter ;

- certains agents IA ont des interprétations différentes des directives.

Il reste malgré tout l’outil standard pour gérer l’accès des crawlers.

Robots.txt et Webflow : ce qu’il faut savoir

Webflow permet de définir un robots.txt personnalisé, mais avec plusieurs limites :

- une seule version possible pour l’ensemble du site ;

- aucune règle conditionnelle ;

- pas de prise en charge native des directives par user-agent spécifiques (comme GPTBot ou ClaudeBot).

Ce générateur comble ces limites en vous permettant de composer, tester et exporter un robots.txt adapté aux moteurs de recherche et aux bots IA modernes, sans aucune configuration technique supplémentaire.

Questions fréquentes sur le fichier robots.txt

Transparence et clarté : voici les réponses aux questions qu’on nous pose le plus.

Et si la vôtre n’y est pas, nous y répondrons avec plaisir.

À quoi sert un robots.txt exactement ?

Ce fichier indique aux crawlers quelles zones de votre site ils peuvent explorer. Il ne protège pas vos données, mais dicte des règles d’indexation aux bots qui choisissent de les respecter.

Les IA respectent-elles vraiment le robots.txt ?

La majorité des bots IA connus déclarent respecter le robots.txt.

Cependant, certains crawlers moins transparents ne le suivent pas strictement.

Le robots.txt reste néanmoins la meilleure méthode déclarative pour contrôler l’accès.

Puis-je bloquer entièrement les IA ?

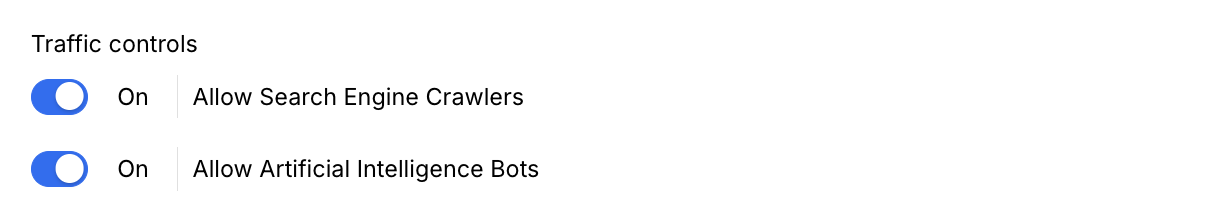

Oui, en désactivant tous les bots IA recommandés dans l’outil ou directement dans Webflow en décochant "Allow Artificial Intelligence Bots" au niveau des settings SEO.

Mais cela peut réduire votre visibilité dans :

- les réponses générées par ChatGPT / Claude

- les citations Perplexity

- les moteurs IA émergents

C’est un choix stratégique.

Comment optimiser l’accès des LLM pour maximiser ma visibilité ?

Pour augmenter la probabilité d’être cité par les IA :

- Autoriser GPTBot, ClaudeBot, Perplexity

- Ne pas restreindre les pages publiques

- Avoir un contenu structuré (Hn, Schema.org, JSON-LD)

- Ajouter un fichier llms.txt

- Produire des pages explicites, pédagogiques et bien formatées

Justa propose une librairie AI Share pour améliorer ça également

Webflow gère-t-il automatiquement les robots.txt IA ?

Non pas directement. Webflow permet d’ajouter un robots.txt classique, mais :

- aucune gestion par user-agent

- aucune mise à jour automatique

- aucune différenciation IA / moteur classique

- aucune gestion dynamique par page

Ce générateur est justement là pour apporter la granularité qui manque actuellement

Quelle est la différence entre robots.txt et llms.txt ?

Le fichier robots.txt est lestandard historique pour les moteurs de recherche classiques alors que le fichier llms.txt est un format expérimental destiné aux modèles IA.

Ces fichiers n’ont pas encore de norme universelle, mais certains bots les lisent déjà. C'est en tout cas une bonne pratique de les intégrer.

Puis-je bloquer uniquement certaines pages pour les IA ?

Oui. Notre outil permet de choisir précisément les bots autorisés et sur quelles pages. Par exemple, on pourrait faire la chose suivante ;

- autoriser Googlebot

- bloquer GPTBot

- bloquer ClaudeBot

- Mais ne pas autoriser le crawl de la page /blog

.svg)